Un bond technologique vers la logistique autonome intelligente

En seulement trois mois, Helix, le robot humanoïde développé pour la logistique, a franchi un nouveau cap. Capable aujourd’hui de manipuler aussi bien des boîtes rigides que des sacs plastiques souples ou des enveloppes plates, Helix rapproche la robotique d’une de ses promesses les plus attendues : l’automatisation complète de la manutention. Grâce à l’intégration d’un module de mémoire visuelle, de capteurs de retour de force et d’un historique d’états, Helix a vu son temps moyen de traitement par colis passer de 5 à 4,05 secondes, tout en augmentant la précision d’orientation des codes-barres à 95 %.

Ces avancées illustrent la puissance des approches d’apprentissage par démonstration. Plutôt que de reposer sur des instructions rigides, Helix apprend directement des comportements humains, comme aplatir un sac plastique pour faciliter la lecture d’un code-barres. Comme le souligne notre expertise en intelligence artificielle, les systèmes apprenants s’adaptent mieux aux environnements dynamiques. Ici, la diversité permanente des colis constitue un terrain d’entraînement idéal pour les réseaux neuronaux. Helix incarne parfaitement l’évolution vers une robotique cognitive adaptative, telle que décrite dans notre vision de la robotique industrielle cognitive.

Des améliorations architecturales clés pour des performances accrues

Derrière les performances de Helix se cachent des innovations techniques majeures. Le module de mémoire visuelle permet au robot de ne plus raisonner à partir d’images instantanées, mais d’avoir une compréhension temporelle de son environnement. Il peut ainsi se souvenir d’un angle de vue optimal pour repérer un code-barres ou éviter les mouvements redondants. Ce type de perception « à mémoire » est essentiel pour garantir la fluidité dans les chaînes logistiques.

Autre avancée notable : l’intégration du retour de force dans le réseau de décision. Helix ressent les contacts, ajuste sa prise, évite les glissements ou les pressions excessives. La réactivité est également décuplée grâce à l’historique d’états du robot, qui assure une manipulation continue même en cas d’interruptions ou de déplacements hasardeux. Ces innovations s’intègrent dans une démarche similaire à celle que propose Leaxea autour de l’automatisation intelligente des processus : des systèmes hybrides alliant vision, mémoire, et perception physique pour une autonomie fiable et robuste dans les environnements complexes.

Vers une collaboration homme-robot naturelle et intuitive

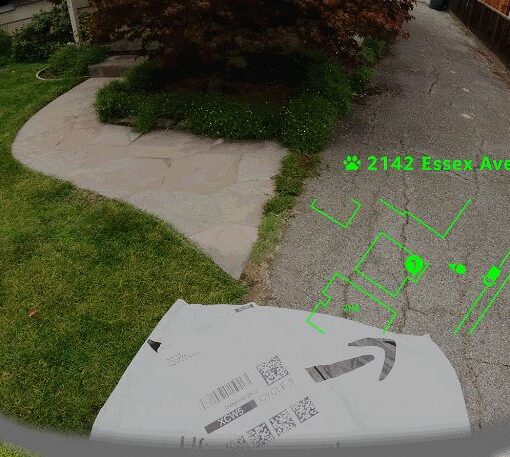

L’un des aspects les plus prometteurs de Helix réside dans sa capacité à interpréter le contexte. Grâce à un petit nombre de démonstrations visuelles, il a appris à répondre à une main tendue : il remet spontanément un colis à un opérateur humain au lieu de le poser sur le convoyeur. Cette interaction fluide, sans mode dédié ni logique programmée, démontre la puissance de l’apprentissage contextuel.

Ce type de comportement ouvre la voie à une collaboration homme-robot plus intuitive, capable de s’adapter aux intentions humaines. Il s’inscrit dans la lignée des solutions de modèles conversationnels IA que nous proposons chez Leaxea pour rendre les systèmes plus réactifs aux signaux humains. Dans le secteur des services, de l’industrie ou de la logistique, cette capacité d’adaptation instantanée permettra de fluidifier les workflows, réduire les erreurs et améliorer la sécurité des collaborateurs.

Conclusion

Helix illustre brillamment comment IA, robotique et apprentissage par démonstration peuvent transformer la logistique moderne :

- +58 % de gain de productivité grâce à l’augmentation des données de formation

- Un taux de succès de 95 % dans l’orientation des colis

- Des comportements adaptatifs et collaboratifs appris sans codage explicite

Chez Leaxea, nous croyons fermement à cette convergence entre perception, adaptation et interaction. Pour découvrir comment la robotique intelligente peut transformer vos projets technologiques, contactez-nous via notre formulaire ou écrivez-nous à contact@leaxea.fr.

Pour en savoir plus, consultez l’article original.